立即释放

北卡罗来纳州立大学的研究人员开发了一种新的最先进的方法,用于控制人工智能(AI)系统如何创建图像。该工作具有从自治机器人到AI培训的领域的应用。

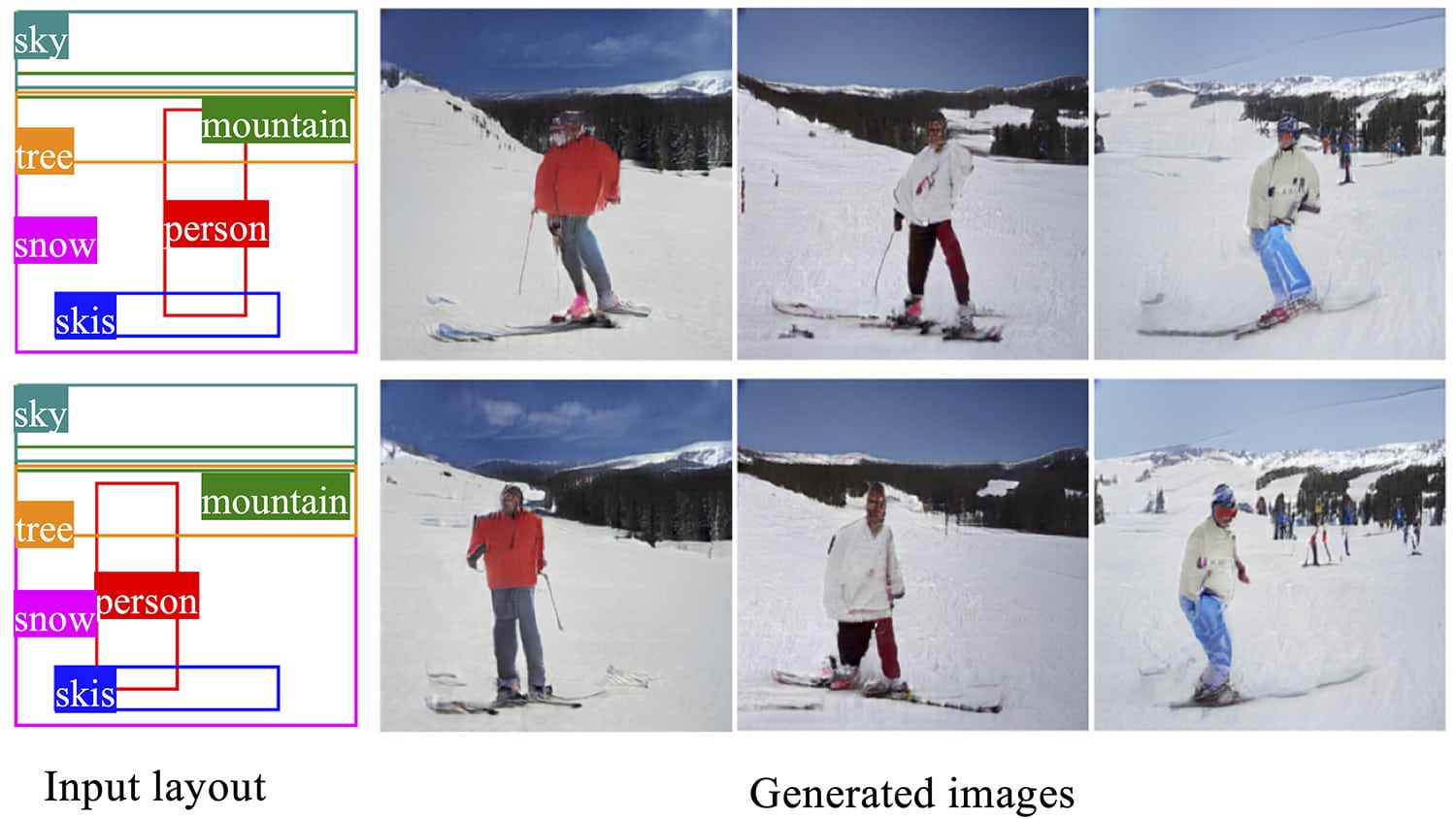

在问题上是一种称为条件图像生成的AI任务,其中AI系统创建符合特定条件集的图像。例如,可以培训系统以创建猫或狗的原始图像,具体取决于用户所要求的动物。最近的技术已经建立在这方面,以合并有关图像布局的条件。这允许用户指定要在屏幕上的特定位置出现的对象。例如,天空可能会进入一个盒子,树可能在另一个框中,流可能位于单独的框中,等等。

新工作构建了这些技术,使用户能够更好地控制所产生的图像,并在一系列图像中保留某些特征。

“我们的方法是高度可重构的,”关于NC国家的计算机工程助理教授的一份文件和助理助理教授Tianfu Wu说。“与以前的方法一样,我们允许用户基于特定条件集生成图像。但我们还允许您保留该图像并添加到它。例如,用户可以让AI创建山景。然后,用户可以将系统添加到该场景中。“

此外,新方法允许用户使AI操纵特定元素,以便它们是相同的,但在某种程度上移动或改变了它们。例如,AI可能会创建一系列图像,显示滑雪者在横跨景观时转向观看者。

“这是一个申请,是为了帮助自主机器人'想象'在开始给定任务之前,最终结果可能看起来像什么,”吴说。“您还可以使用该系统生成AI培训的图像。因此,您可以使用此系统来创建其他AI系统的图像来使用此系统来编译图像。“

研究人员使用Coco-Stuft DataSet和视觉基因组数据集进行了新的方法。基于图像质量的标准测量,新方法表现出先前的最先进的图像创建技术。

“我们的下一步是看看我们是否可以将这项工作扩展到视频和三维图像,”吴说。

新方法培训需要公平的计算能力;研究人员使用了一个4-GPU工作站。但是,部署系统的计算较低。

“我们发现一个GPU为您提供了几乎实时速度,”吴说。

“除了我们的论文,我们已经制作了我们在GitHub上提供此方法的源代码。也就是说,我们总是开放与行业合作伙伴合作。“

本文,“学习布局和款式可重新配置GAN可控制图像合成,“发表在期刊上图案分析和机器智能的IEEE交易。本文的第一个作者是魏太阳,最近的博士。从NC状态毕业。

该工作得到了国家科学基金会的支持,下属1909644年,1822477,2024688和2013451;由美国陆军研究办公室授予批准W911NF1810295;并由社区生活管理局授予90IFDV0017-01-00。

- 船员 -

编辑注:研究摘要跟随。

“用于可控图像合成的学习布局和样式可重新配置GANS”

作者:Wei Sun和Tianfu Wu,北卡罗来纳州立大学

发表:5月10日,图案分析和机器智能的IEEE交易

迪伊:10.1109 / TPAMI.2021.3078577

摘要:在最近的最近学习深层生成模型的进展中,开发可控制图像合成的模型变得越来越有趣,从可重新配置的结构输入开发。This paper focuses on a recently emerged task, layout-to-image, whose goal is to learn generative models for synthesizing photo-realistic images from a spatial layout (i.e., object bounding boxes configured in an image lattice) and its style codes (i.e., structural and appearance variations encoded by latent vectors). This paper first proposes an intuitive paradigm for the task, layout-to-mask-to-image, which learns to unfold object masks in a weakly-supervised way based on an input layout and object style codes. The layout-to-mask component deeply interacts with layers in the generator network to bridge the gap between an input layout and synthesized images. Then, this paper presents a method built on Generative Adversarial Networks (GANs) for the proposed layout-to-mask-to-image synthesis with layout and style control at both image and object levels. The controllability is realized by a proposed novel Instance-Sensitive and Layout-Aware Normalization (ISLA-Norm) scheme. A layout semi-supervised version of the proposed method is further developed without sacrificing performance. In experiments, the proposed method is tested in the COCO-Stuff dataset and the Visual Genome dataset with state-of-the-art performance obtained.

- 类别: